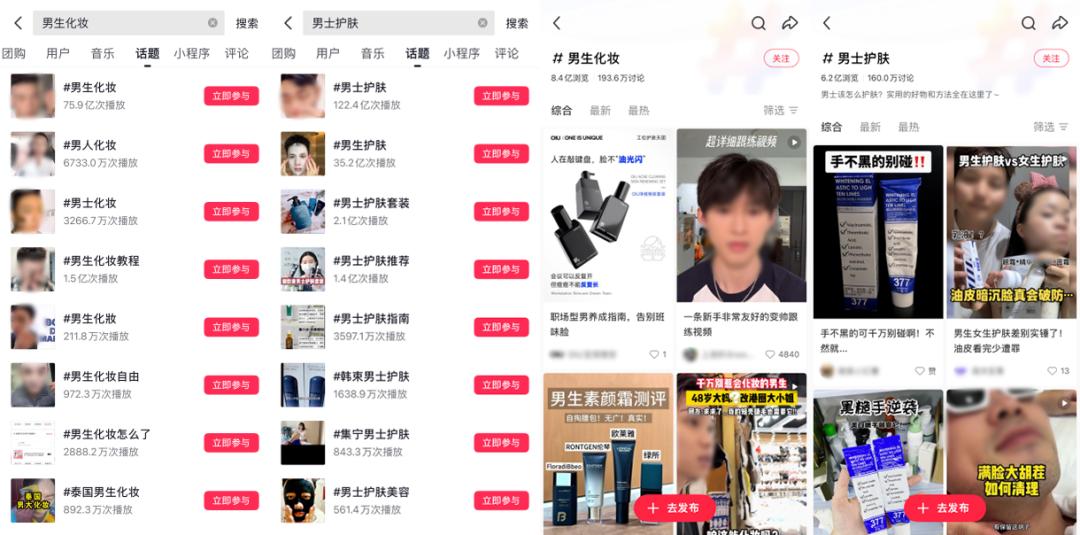

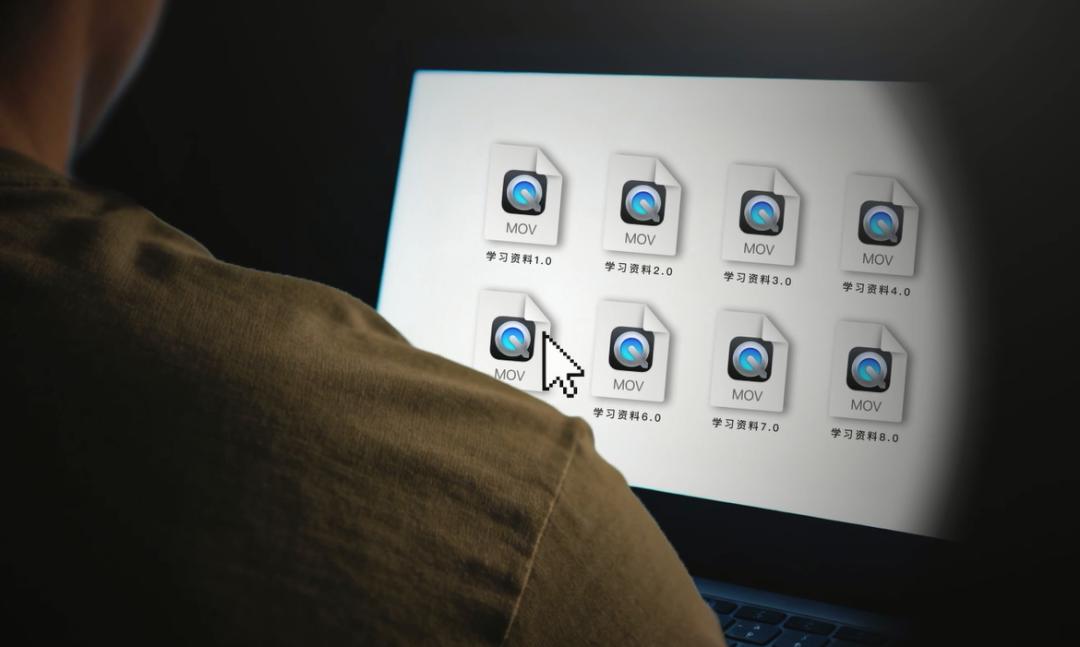

最近,各大网盘又悄悄开启了一轮“净网行动”,各位老司机们是不是像往常一样点开那个自己珍藏多年的“学习资料”文件夹,熟练地点开一个视频,准备回温一下经典电影。

结果屏幕上弹出的却不是熟悉的画面,而是一行冰冷的违规提示词,还有那段熟悉的 8 秒净网教育宣传片。

那一刻,你珍藏多年的学习资料,就在这 8 秒的循环播放中,化为了乌有。

在这一刻,我相信一个巨大的问号会盘旋在每个人的脑海中:“难道真的有人在后台一个一个地审查我的文件吗?

但稍微冷静下来想一想,这其实也不太现实。我们来看一组公开数据做个参考:

早在几年前,国内某家头部的网盘平台就已宣布,用户数突破 8 亿,存储数据总量超过 1000 亿 GB,这种天文级别的数字,想要靠人工团队去进行地毯式审核,无异于大海捞针,根本不可能完成。

那么问题就来了:既然大规模的人工审查不现实,网盘又是如何做到精准识别,甚至秒删那些违规文件的呢?

这次我们就来聊一聊,看看网盘底是是如果做到精准删除你的文件的。

在要搞清楚“怎么做”之前,我们得先搞懂“为什么”。平台花这么多钱和精力,冒着被我们疯狂吐槽的风险也要删文件,这绝对不是无缘无故的。简单来说,背后主要有三个原因。

第一、也是最根本的,是法律法规的硬性要求。

这方面,有一个绕不过去的经典案例——快播,我相信各位老网民都还记忆犹新,当年,快播凭借其独特的 P2P 点播技术,几乎成了盗版和色情内容的法外之地。

但最终的结局是什么?公司被处以天价罚款,平台被封,创始人锒铛入狱。

快播这个案例就像一声惊雷,给整个中国互联网行业敲响了警钟,从那时起,平台方就必须对服务器上的内容安全负责。

根据法律规定,如果平台不主动审查和处理违规信息,就会面临从罚款到负责人被追究刑事责任等一系列严重后果。

所以,主动清理违规内容,对所有网盘来说,根本不是一道选择题,而是一项法律义务。

第二、来自海量的版权投诉压力。

你存在云盘里的各类影视、付费课程、破解版软件等等,可都不是无主之物,它们的背后站着的是无数拥有强大法务团队的公司。

放眼全球,这类版权攻防战同样激烈。

一个标志性的案例就是曾经的网盘巨头 Megaupload 的倒下。

2012 年,这个在全球拥有海量用户的网站因多项罪名被美国司法部强制关闭,其中一条就是因平台上的盗版内容给版权方造成了超过上亿美元的损失而遭到逮捕。

这一事件在全球范围内都引发了巨大震动。

同样,在国内,随便在新闻里搜索一下网盘侵权也是能看到很多具体的案例,近年来,国内持续开展的净网行动,更是屡次将矛头直指网盘的盗版问题。

这些版权方,要么自己组建维权团队,要么委托第三方机构,全天不间断地全网监控。

一旦发现侵权,雪片般的侵权通知函就会抵达平台,为此,平台必须删,不删就得当被告、吃官司、赔钱。在这场无穷无尽的版权攻防战里,平台能做的,只能是“宁可错杀,也不放过”。

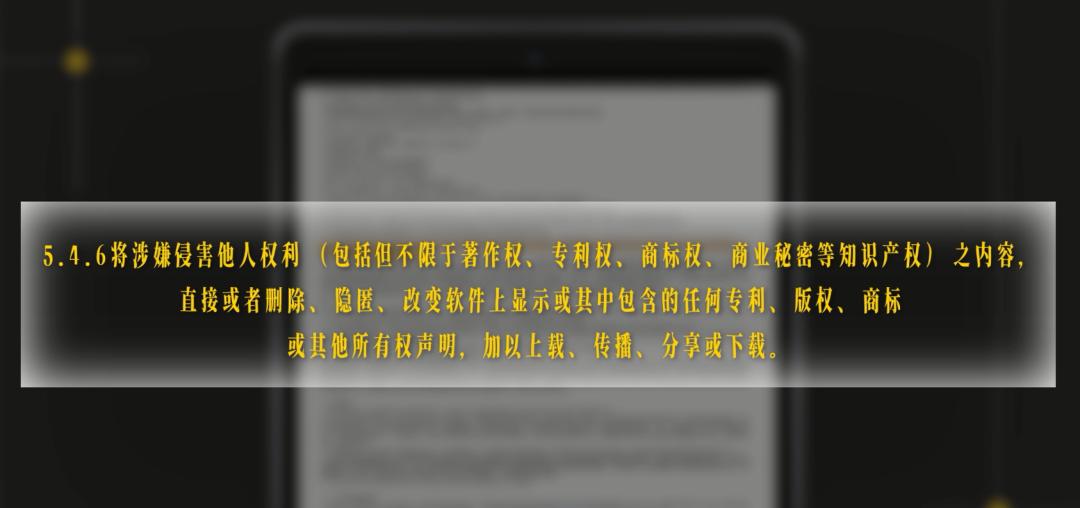

至于第三点,也是最无奈的一点,平台能这么做的底气,来源于你自己,没错,还是那个经典的免责声明——用户协议。

我知道,那玩意儿又臭又长,99.9% 的人都不会看。但里面确实都写的清清楚楚:用户不得上传和分享违法、侵权内容,平台有权在不通知的情况下,对违规文件进行处理。

当你勾选同意的那一刻,就相当于为平台的操作签了一份“授权书”。所以,于情于理于法,平台都有充足的理由,名正言顺地对我们的文件进行筛查了。

好,搞清楚了“为什么”,我们再来探讨技术层面的核心问题:这套检测系统是如何运作的?

为了兼顾效率与准确性,这套系统通常采用一种层层递进的过滤策略,就像一个多层过滤网,先把最明显的问题过滤掉,再进行更精细的分析。这个过程大致遵循以下顺序

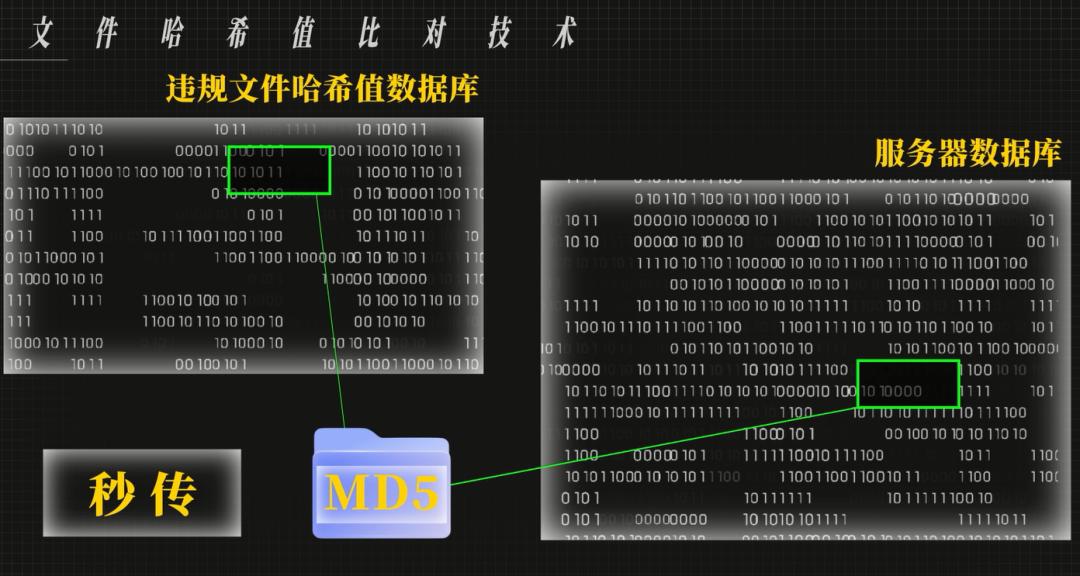

第一层过滤采用文件哈希值比对技术。哈希值可理解为文件的“数字指纹”,由特定算法,如常用的 MD5,根据文件内容生成一串独一无二的字符串。

该指纹仅取决于内容本身,与文件名无关,且任何微小改动都会产生巨大差异。

这项技术常见于网盘的“秒传”功能:上传文件时,系统计算其 MD5 值并与服务器数据库比对。

若匹配,则说明文件已存在,无需重复上传,仅需建立链接即可,极大节省时间和带宽。

同理,平台通过建立“违规文件哈希值数据库”,在上传时快速计算和比对文件 MD5 值。一旦匹配,就可以判定为已知违规内容,立即中断或标记上传。

该方法成本低、速度快,并且能高效过滤大部分已知违规文件。

第二层过滤:文件名关键词扫描。

这一层很好理解,这项技术会自动扫描你上传或分享的文件名。如果文件名中包含了“破解版”、“枪版”、“未删减”等高风险的关键词,文件就会被系统标记为“疑似目标”,可能会直接禁止分享,或者进入更深层次的人工智能审查环节。

当然,规则是死的,人是活的,你永远可以相信民间大神这一富有创造力和想象力的庞大群体,当一套审查规则被清晰地摆上台面后,各路大神就纷纷开始整活。

从一开始修改后缀名、使用加密压缩包,再到通过给视频加片头或重新编码来微调内容等等,这些操作让传统检测方法一度失效。

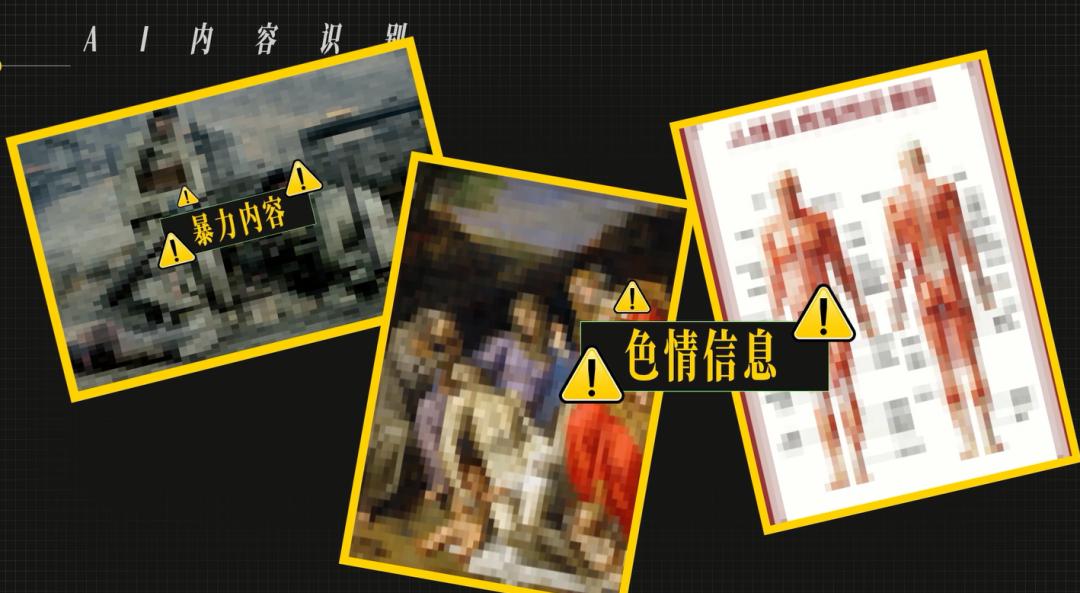

为了应对这种上有政策,下有对策的局面,技术含量更高的 AI 内容识别就成了必然选择。

这是目前技术含量最高,也是计算成本最高的一层。

它主要处理那些通过了前两层筛查,但又被标记为“疑似”的文件。如果说哈希值比对的是文件的“身份证”,那么 AI 技术则像是具备了直接阅读和理解内容本身的能力。

通过深度学习算法训练,AI 模型可以直接分析图片或视频的画面内容,识别出其中是否包含色情、暴力、血腥等违规元素。

除此之外,平台还会辅以强大的风控系统作为补充 。

这套系统会实时分析用户的行为模式,例如一个账号在短时间内将同一个文件分享给大量用户,这种异常传播行为会独立触发系统的限制和审查,从而形成一个“内容”与“行为”双重过滤的立体防御体系。

不过,AI 识别也并非百分百准确。它的算法模型仍然存在局限,有时会发生判断失误,这也就是很多文件被误伤的原因。

举个例子,一些包含战争场景的历史纪录片,有可能被系统错标为暴力内容;某些艺术品照片或医学教学图,也可能因为画面被算法误解为色情信息。

当机器的判断过于一刀切时,不仅会影响用户的正常文件,也会引发许多用户不满。为了弥补机器审核的不足,并处理这些复杂的边界情况。

还存在最后一道防线——人工审核。

但这并非大家想象中的大规模排查,而是作为自动化系统的补充和最终裁定环节。

人工审核通常只介入几种特定情况:比如,处理被AI系统标记为“高度疑似”但机器无法最终确认的文件;复核被用户多次举报的内容;以及处理用户的申诉请求等。

人工团队的角色更像是法官,负责对机器筛选出的疑难问题进行精准判决。

以上就是这套检测系统运转的过程,这场技术攻防至今仍在继续,但总体趋势是,随着 AI 技术的不断进步,个人用户想通过简单的技巧来绕过一个平台级的、由海量数据驱动的审查系统,正变得越来越困难。

这种变换,也让很多老用户肯定都有一个共同的感受:以前的网盘,好像没这么严,现在的网盘,简直就是滴水不漏。

这背后,其实反映了整个互联网商业模式的进化。

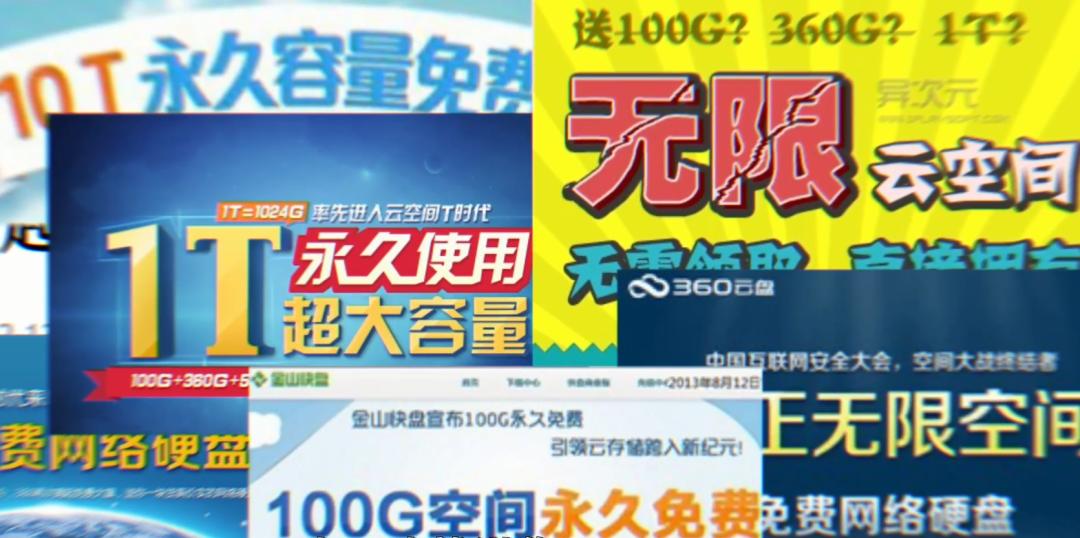

在过去,那个野蛮生长的时代,各大厂商的核心目标就一个字:抢,抢用户,还记得当年的“百盘大战”吗?

百度、360、华为、金山,各路巨头纷纷下场,动不动就送你 1T、10T 甚至 36T 的永久免费空间。

用这种海量的免费空间,加上相对宽松的审查环境,不管三七二十一,先把用户拉到我的平台上再说,那个时候,用户量就是一切。

而现在,市场格局基本稳定,进入了注重商业回报的时代。商业化的压力上来了,平台的运营目标从拉新,变成了盈利和服务好付费用户。

这时候,那些只在网盘里存几个T的盗版电影和破解软件,占用着大量服务器带宽和存储成本,却一毛钱都不想花的白嫖用户,在平台眼里,就逐渐从潜在客户,变成了高成本负资产。

所以,收紧审查标准,对平台来说,是一举多得。既能降低法律和版权风险,又能有效节约服务器开销。更重要的是,通过清理盗版资源,可以劝退那些低价值用户,同时促使那些真正有稳定、安全存储需求的用户,去为更优质的服务买单。

就像一些新兴的网盘,从诞生之初就采取严格的审查策略,它的目的,就是为了直接筛选出那批高质量的核心用户。

这就是商业层面上的原因。

理解了这些技术和商业层面的原因后,我们不妨把视角拉回到用户本身,看看这件事对我们究竟意味着什么。

当用户发现自己珍藏的影片、资料乃至个人备份,在未经通知的情况下变为无法访问的状态时,带来的感受是一种对个人数字财产失控的愤怒与无奈。

许多用户将网盘视为一个绝对私密、可靠的数字保险箱。然而,这种期望与平台的运营现实之间存在着一道鸿沟。

平台方不仅要承载海量的数据存储和带宽成本,更要在法律法规和版权方的双重高压下运行。它们必须对服务器上的海量内容负责,任何疏忽都可能导致严重的法律后果。

这种矛盾,使得用户对数据“数据所有权”的认知变得模糊,用户认为自己租用的是一块私人空间,但对于平台而言,它提供的更像是一项必须接受监管的公共服务。

在这种模式下,平台方扮演了服务提供者和内容监管者的双重角色,而用户在享受便利的同时,也不得不让渡出一部分对数据的绝对控制权。

所以,真正值得我们讨论的,已经不仅仅是文件消失本身了。

本文来自微信公众号“科技狐”,作者:老狐。