8月29日,由清华大学计算机系崔鹏教授团队联合稳准智能共同研发的结构化数据通用大模型“极数”(LimiX)正式宣布开源。此次发布标志着我国在结构化数据智能应用领域的技术突破与生态开放迈出了关键一步,将显著降低千行百业的AI技术门槛。特别是在结构化数据占主导的泛工业领域,“极数”大模型将助力AI深度融入工业生产全流程,破解工业数据价值挖掘难题,为实现智能制造与新型工业化提供关键支撑,推动产业技术变革和优化升级。

泛工业领域渴求准确高效的结构化数据智能应用技术

在泛工业领域,结构化数据是核心资产——工业生产参数、设备运行数据、质量检测数据、科研实验数据等均以结构化数据形式呈现,其智能处理能力直接影响产业效率与科研突破,也是AI赋能工业制造的关键突破口。虽然通用语言大模型(LLM)已在内容创作、对话交互等领域实现广泛应用,但在面对表格、时序等结构化数据时短板明显:数值比较、计算等基础任务易出偏差,更无法胜任数据分类、预测、归因等复杂任务,准确率难以满足真实行业需求。因此,目前工业结构化数据处理依然高度依赖私有数据+专用模型的传统范式。又因为专用模型难泛化、不通用,面对不同场景需要训练多个专用模型,成本高、效果差,且难以发挥数据要素聚集的乘数效应,严重制约了AI在工业场景的落地路径。

结构化数据通用大模型(LargeDataModel,LDM)则针对性地解决了这些痛点:不同于通用语言大模型聚焦文本,通用数据大模型基于因果合成数据进行预训练,既能捕捉结构化数据的内在关联,又具备强泛化能力,可跨行业适配多类任务。“极数”大模型可以支持分类、回归、高维表征抽取、因果推断等多达10类任务,性能达到甚至超越最优专用模型,在工业时序预测、异常数据监测、材料性能预测等场景中,实现单一模型适配多场景、多任务的通用性突破,为人工智能赋能工业提供了One-For-All解决方案。

“极数”模型在多领域任务中获得性能突破

“极数”模型的研发核心团队由国家杰出青年科学基金获得者、国家自然科学二等奖得主、国际计算机协会(ACM)杰出科学家、清华大学计算机系崔鹏教授牵头组建,团队兼具学术研究深度与产业落地能力。

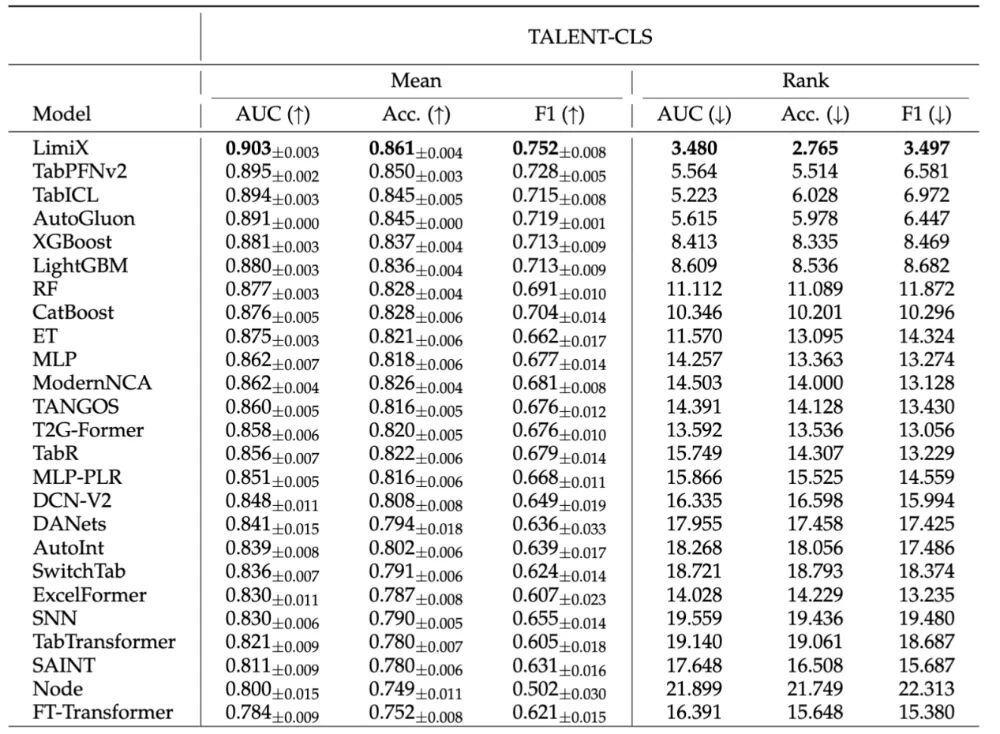

“极数”模型在评测方面,选取了各个领域的权威数据集作为Benchmark。如开源数据集Talent,它包含上百个真实数据集,是当前领域内体量最大、最具代表性的基准之一。在分类任务中,对比“极数”与24个领域内的最优模型,“极数”大模型的模型性能显著超越其他模型,在AUC、ACC、F1Score和ECE上均取得了最优。

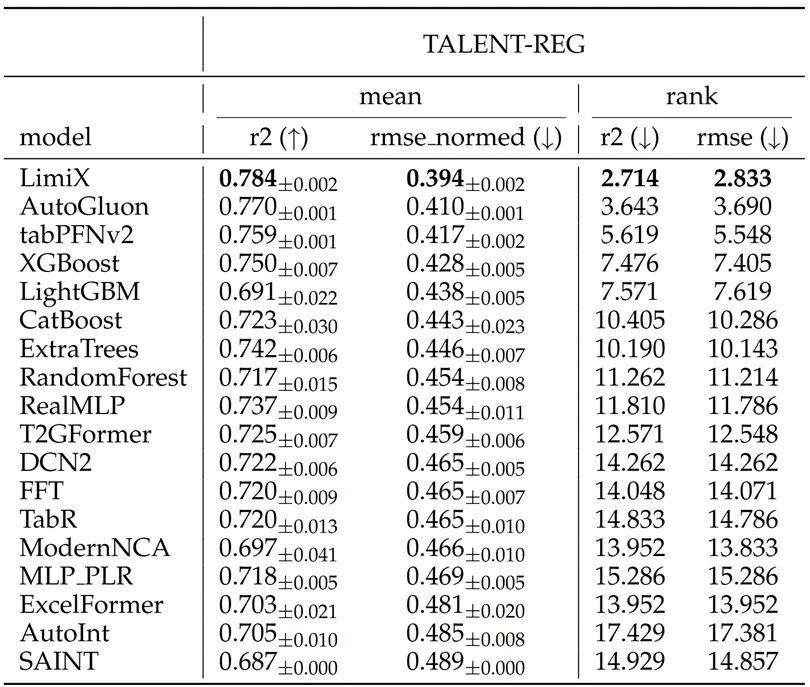

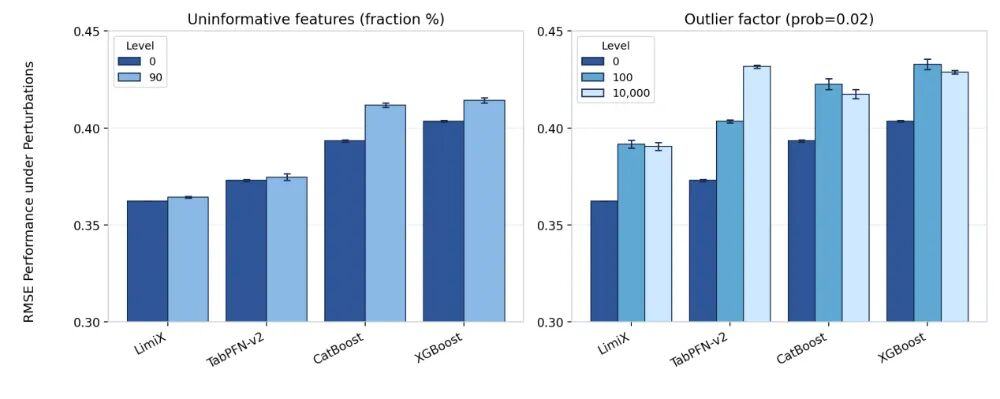

在回归任务上,“极数”大模型在R2和RMSE指标上都达到了平均最优,对比其他最优模型展现出了明显的优势。并且在数据集中有干扰特征或无效特征时,性能优势更加明显。

“极数”是怎么样炼成的?

在现代产业中,无论是工业数据分析、金融风险预测,还是医疗数据研究,均深度依赖传统专用模型处理结构化数据。然而,传统专用模型长期存在过度依赖高质量数据、黑盒、不可解释性以及通用性、泛化性差等一系列核心痛点,严重制约了AI技术在结构化数据处理场景中的落地效率与应用范围。针对这些痛点,“极数”大模型在开发过程中已完全实现技术突破。

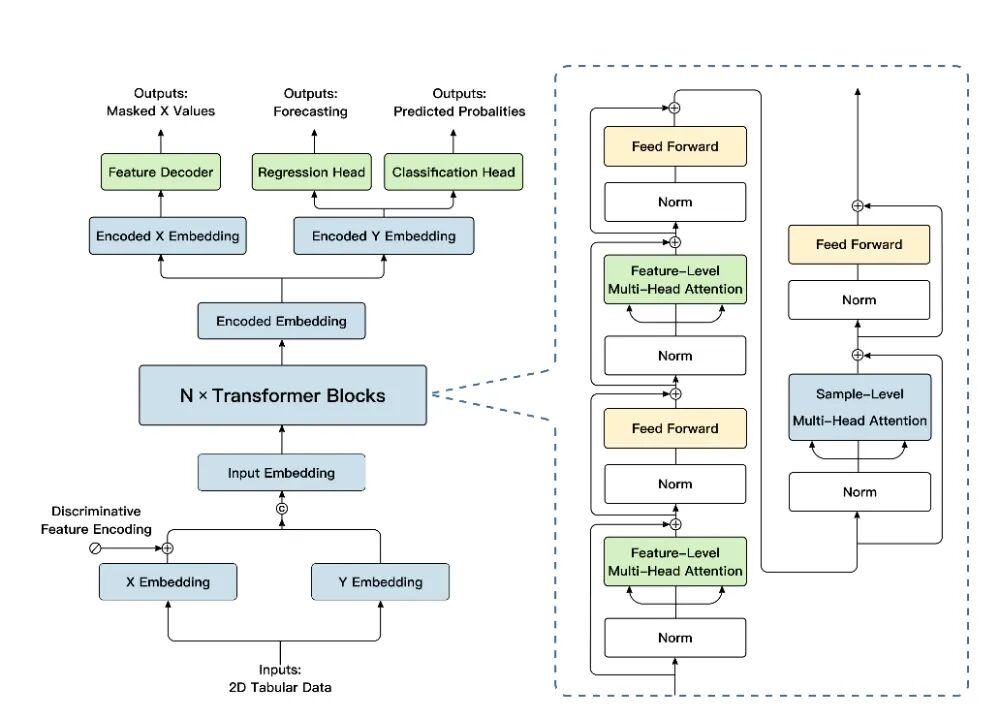

“极数”大模型沿用了transformer架构,并针对结构化数据建模和任务泛化进行了相关的优化。“极数”大模型先对先验知识库中的特征X和目标Y分别进行embedding;之后在主要模块中,在样本和特征维度上分别使用注意力机制,来聚焦关键样本的关键特征。最终,提取到的高维特征被分别传入regressionhead和classificationhead,实现对不同功能的支持。

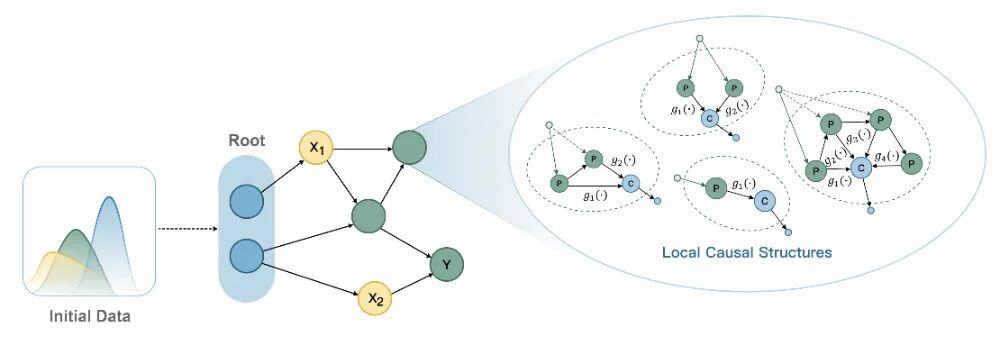

不同于传统的树模型和基于transformer架构的通用语言大模型,“极数”大模型在预训练过程中完全使用生成数据,不依赖于任何真实世界的数据来源。为了使数据生成的过程高效且可控,团队使用了基于结构因果图的数据生成方式:采样到的初始数据在有向无环图上进行传播,通过复杂的边映射和节点交互来模拟现实世界中不同的因果依赖关系;通过对因果图上的生成数据进行采样,最终获得训练数据中的特征X和目标Y。使用这种方法生成的数据,既实现了因果结构上的多样性,又保证了数据的可控性。

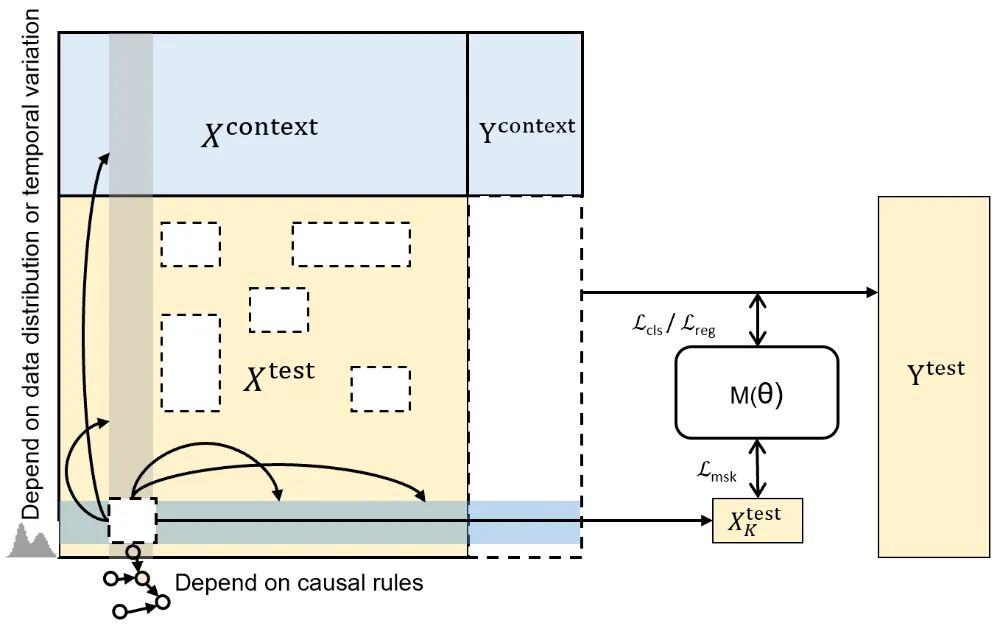

通用数据大模型(LDM)需要在各种应用场景的各种任务中通用,且具备无需进行训练的数据建模能力。因此需要对数据的联合分布进行建模,以提高模型的通用性、增强对特征交互模式的建模能力。为此,“极数”大模型在模型优化目标设计中加入了掩码重构机制:在训练过程中,通过对随机特征值进行掩码操作,模型将根据特征间的因果依赖关系,使用观测到的特征来重构缺失特征。为了更贴近真实场景中的缺失模式,“极数”大模型在三个维度上进行了样本维度掩码、特征维度掩码和语义维度掩码。通过引入掩码预测,模型可以学习到数据特征的联合分布,学习到更清晰且鲁棒的决策边界,提高对特征依赖关系的表示学习能力。

在推理应用环节,“极数”大模型具备极强的场景适配性与任务灵活性。该模型无需针对特定场景或任务进行额外训练,即可直接接收表格、时序、图等多形态结构化数据输入;用户仅需明确分类预测、回归预测、缺失值补全、数据生成、因果推断、因果发现等具体任务类型,模型即可自动完成数据解析、逻辑建模与结果输出,真正实现即插即用、高效覆盖各类结构化数据处理需求。

此外,“极数”大模型还支持针对数据集进行模型高效微调,可使模型学习更全面的数据中的因果联系,在预测层面的性能会进一步提升。

“极数”已在多个关键工业场景中成功落地

目前,“极数”大模型凭借其优越的通用建模能力,有效破解了传统专用模型在工业场景“数据稀缺、质量参差、环境异质”情况下的能力瓶颈,已在多个关键工业场景中成功落地。

在工业运维领域,“极数”大模型已成功应用于钢铁、能源电力等行业,为设备运行监测、故障预警与健康度评估等任务提供核心支撑。以某钢铁企业为例,其复杂产线长期面临难以从海量传感数据中精准捕捉非典型异常信号而导致的预警失效问题,给安全生产带来巨大隐患。“极数”大模型部署后,将设备故障预测准确率在原专用模型基础上提升了15%,达到应用级要求,推动其维护模式从“事后维修”向“预测性维护”转型,显著提升了生产的安全性与运行效率。

在工艺优化领域,“极数”大模型在化工、制造、生物等行业中化身为“生产智囊”。在某材料研发企业,如何从海量物化特征中精准识别关键因子,是提升材料设计效率的核心瓶颈。“极数”大模型成功筛选出少数核心优化因子,在确保信息无损(R^2超过0.95)的前提下,将调控效率提升了5倍,为企业的降本增效与绿色生产提供了科学决策依据。

业内专家表示,“极数”大模型的成功落地不仅验证了通用建模技术在工业场景的适用性,更为解决工业数据应用痛点提供了标准化解决方案,有望推动更多工业领域实现智能化升级。

目前,“极数”大模型已经开源,在Github、Huggingface、Modelscope等平台搜索LimiX即可查询。

在当前人工智能的发展浪潮中,大语言模型(LLM)通过大规模预训练实现了“语义空间的通用世界模型”,而如何面向工业数据的独特属性,构建“数据空间的通用世界模型”,已成为AI迈向产业纵深的关键命题。在这一目标的驱动下,发展能够跨场景、跨任务、跨环境的结构化数据通用大模型(LDM)势在必行。我国凭借丰富的工业数据资源与多元的应用场景,有望在该领域打造出独特的“非对称竞争力”。清华大学团队此次开源发布的“极数”大模型,正是这一方向上的重要突破。期待以此为起点,共同迎接通用数据大模型的“GPT-3时刻”早日到来。